畢設系列-基于YOLOV5的手勢識別系統

我們之前做過一期基于Yolov5的口罩檢測系統(手把手教你使用YOLOV5訓練自己的目標檢測模型-口罩檢測-視頻教程_dejahu的博客-CSDN博客),里面的代碼是基于YOLOV5 6.0開發的,并且是適用其他資料集的,只需要修改資料集之后重新訓練即可,非常方便,但是有些好兄弟是初學者,可能不太了解資料的處理,所以我們就這期視頻做個衍生系列,主要是希望通過這些系列來教會大家如何訓練和使用自己的資料集,

本期我們帶來的內容是基于YOLOV5的手勢識別系統,我們將會訓練得到能識別10種常用手勢的模型,廢話不多說,還是先看效果,

B站視頻:畢設系列-檢測專題-基于YOLOV5的手勢識別系統_嗶哩嗶哩_bilibili

代碼地址:YOLOV5-hand-42: 基于YOLOV5的手勢識別系統 (gitee.com)

資料集和訓練好的模型地址: YOLOV5手勢識別資料集+代碼+模型2000張標注好的資料+教學視頻-深度學習檔案類資源-CSDN文庫

考慮到有的朋友算力不足,我這里也提供了標注好的資料集和訓練好的模型,獲取方式是通過CSDN付費下載,資源地址如下:

YOLOV5手勢識別資料集+代碼+模型2000張標注好的資料+教學視頻-深度學習檔案類資源-CSDN文庫

需要遠程除錯的小伙伴和課程設計訂做的小伙伴可以加QQ 3045834499,價格公道,童叟無欺,

下載代碼

代碼的下載地址是:YOLOV5-hand-42: 基于YOLOV5的手勢識別系統 (gitee.com)

配置環境

不熟悉pycharm的anaconda的小伙伴請先看這篇csdn博客,了解pycharm和anaconda的基本操作

如何在pycharm中配置anaconda的虛擬環境_dejahu的博客-CSDN博客_如何在pycharm中配置anaconda

anaconda安裝完成之后請切換到國內的源來提高下載速度 ,命令如下:

conda config --remove-key channels

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/pytorch/

conda config --set show_channel_urls yes

pip config set global.index-url https://mirrors.ustc.edu.cn/pypi/web/simple

首先創建python3.8的虛擬環境,請在命令列中執行下列操作:

conda create -n yolo5 python==3.8.5

conda activate yolo5

pytorch安裝(gpu版本和cpu版本的安裝)

實際測驗情況是YOLOv5在CPU和GPU的情況下均可使用,不過在CPU的條件下訓練那個速度會令人發指,所以有條件的小伙伴一定要安裝GPU版本的Pytorch,沒有條件的小伙伴最好是租服務器來使用,

GPU版本安裝的具體步驟可以參考這篇文章:2021年Windows下安裝GPU版本的Tensorflow和Pytorch_dejahu的博客-CSDN博客

需要注意以下幾點:

- 安裝之前一定要先更新你的顯卡驅動,去官網下載對應型號的驅動安裝

- 30系顯卡只能使用cuda11的版本

- 一定要創建虛擬環境,這樣的話各個深度學習框架之間不發生沖突

我這里創建的是python3.8的環境,安裝的Pytorch的版本是1.8.0,命令如下:

conda install pytorch==1.8.0 torchvision torchaudio cudatoolkit=10.2 # 注意這條命令指定Pytorch的版本和cuda的版本

conda install pytorch==1.8.0 torchvision==0.9.0 torchaudio==0.8.0 cpuonly # CPU的小伙伴直接執行這條命令即可

conda install pytorch torchvision torchaudio cudatoolkit=11.3 -c pytorch # 30系顯卡的小伙伴執行這里的指令

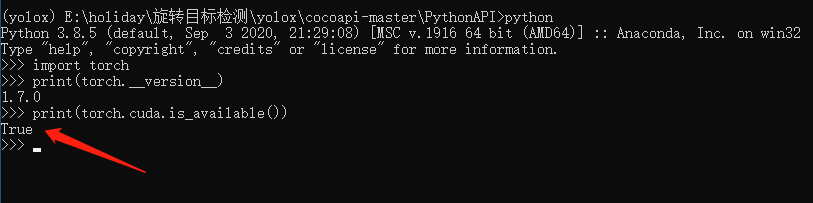

安裝完畢之后,我們來測驗一下GPU是否

pycocotools的安裝

后面我發現了windows下更簡單的安裝方法,大家可以使用下面這個指令來直接進行安裝,不需要下載之后再來安裝

pip install pycocotools-windows

其他包的安裝

另外的話大家還需要安裝程式其他所需的包,包括opencv,matplotlib這些包,不過這些包的安裝比較簡單,直接通過pip指令執行即可,我們cd到yolov5代碼的目錄下,直接執行下列指令即可完成包的安裝,

pip install -r requirements.txt

pip install pyqt5

pip install labelme

資料處理

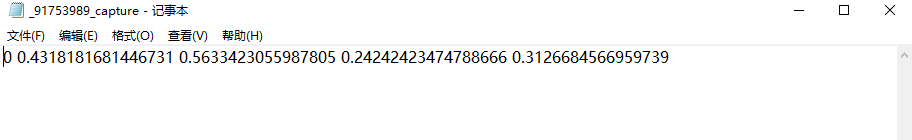

實作準備處理好的yolo格式的資料集,一般yolo格式的資料是一張圖片對應一個txt格式的標注檔案,

標注檔案中記載了目標的類別 中心點坐標 和寬高資訊,如下圖所示:

記住這里的資料集位置,在后面的組態檔中我們將會使用到,比如我這里資料集的位置是:C:/Users/chenmingsong/Desktop/hand/hand_gesture_dataset

組態檔準備

-

資料組態檔的準備

組態檔是data目錄下的

hand_data.yaml,只需要將這里的資料集位置修改為你本地的資料集位置即可,

-

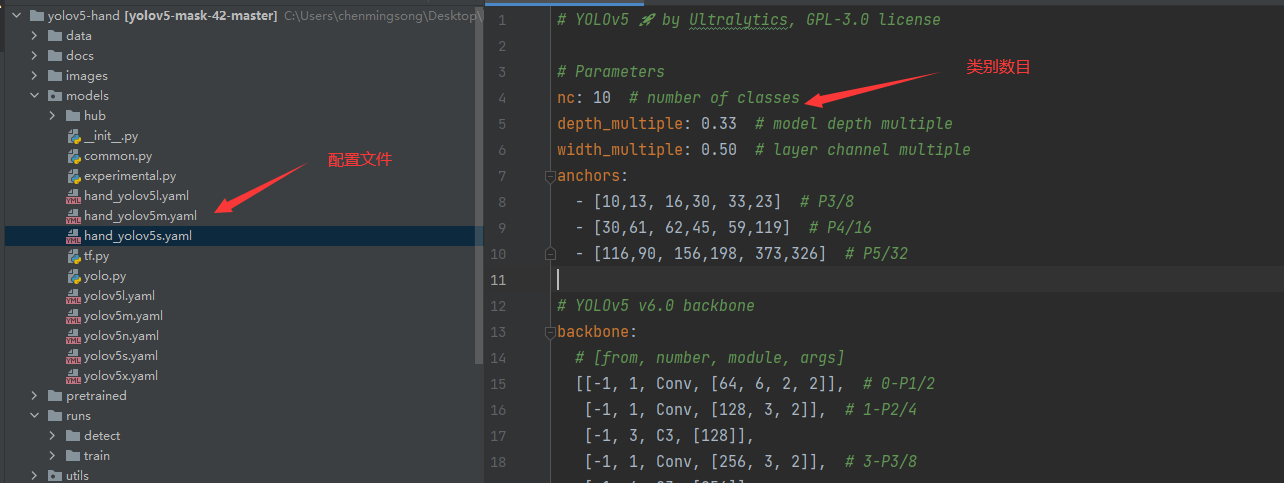

模型組態檔的準備

模型的組態檔主要有三個,分別是

hand_yolov5s.yaml、hand_yolov5m.yaml、hand_yolov5l.yaml,分別對應著yolo大中小三個模型,主要將組態檔中的nc修改為我們本次資料集對應的10個類別即可,

模型訓練

模型訓練的主檔案是train.py,下面的三條指令分別對應著小中大三個模型的訓練,有GPU的同學可以將設備換為0,表示使用0號GPU卡,顯存比較大的同學可以將batchsize調整為4或者16,訓練起來更快,

python train.py --data hand_data.yaml --cfg hand_yolov5s.yaml --weights pretrained/yolov5s.pt --epoch 100 --batch-size 2 --device cpu

python train.py --data hand_data.yaml --cfg hand_yolov5l.yaml --weights pretrained/yolov5l.pt --epoch 100 --batch-size 2

python train.py --data hand_data.yaml --cfg hand_yolov5m.yaml --weights pretrained/yolov5m.pt --epoch 100 --batch-size 2

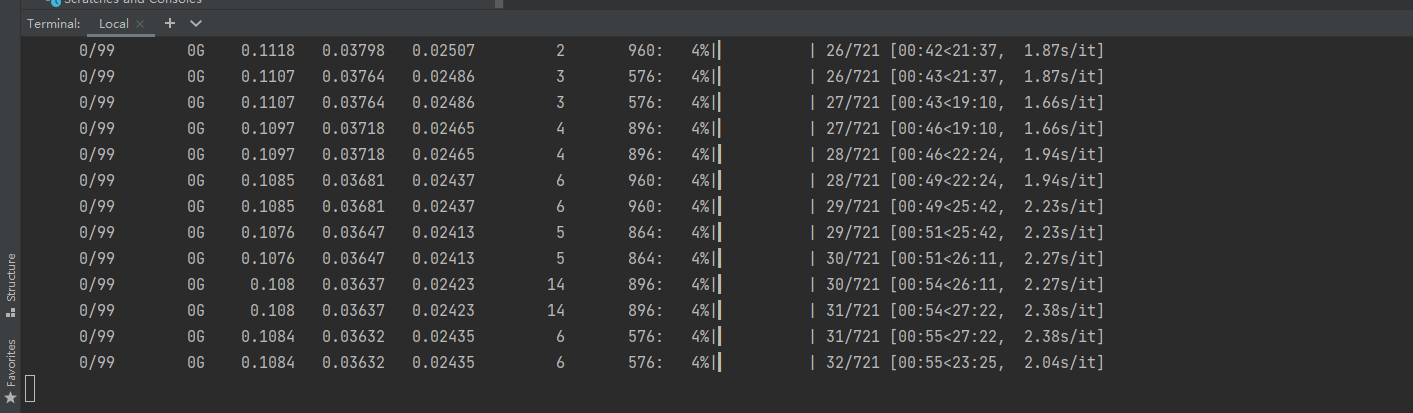

訓練程序中會出現下面的進度條

等待訓練完成之后訓練結果將會保存在runs/train目錄下,里面有各種各樣的示意圖供大家使用,

模型使用

模型的使用全部集成在了detect.py目錄下,你按照下面的指令指你要檢測的內容即可

# 檢測攝像頭

python detect.py --weights runs/train/exps/weights/best.pt --source 0 # webcam

# 檢測圖片檔案

python detect.py --weights runs/train/exps/weights/best.pt --source file.jpg # image

# 檢測視頻檔案

python detect.py --weights runs/train/exps/weights/best.pt --source file.mp4 # video

# 檢測一個目錄下的檔案

python detect.py --weights runs/train/exps/weights/best.pt path/ # directory

# 檢測網路視頻

python detect.py --weights runs/train/exps/weights/best.pt 'https://youtu.be/NUsoVlDFqZg' # YouTube video

# 檢測流媒體

python detect.py --weights runs/train/exps/weights/best.pt 'rtsp://example.com/media.mp4' # RTSP, RTMP, HTTP stream

比如以我們的口罩模型為例,如果我們執行python detect.py --weights runs/train/exps/weights/best.pt --source data/images/0023.png的命令便可以得到這樣的一張檢測結果,

構建可視化界面

可視化界面的部分在window.py檔案中,是通過pyqt5完成的界面設計,在啟動界面前,你需要將模型替換成你訓練好的模型,替換的位置在window.py的第60行,修改成你的模型地址即可,如果你有GPU的話,可以將device設定為0,表示使用第0行GPU,這樣可以加快模型的識別速度嗷,

現在啟動看看效果吧,

找到我

你可以通過這些方式來尋找我,

B站:肆十二-

CSDN:肆十二

知乎:肆十二

微博:肆十二-

現在關注以后就是老朋友嘍!

轉載請註明出處,本文鏈接:https://www.uj5u.com/qita/438642.html

標籤:AI